1. Пусть x1, x2, …, xp – p наблюдаемых признаков,  – результаты i-го наблюдения признаков, i = 1, 2, …, n, Х = (xij) – матрица наблюдений (исходных данных). В факторном анализе предполагается, что xj является линейной комбинацией m линейно независимых факторов, так называемых «общих факторов» f1, f2, …, fm, плюс «специфический» для данного признака фактор ei, некоррелированный ни с общими факторами, ни с другими специфическими факторами,

– результаты i-го наблюдения признаков, i = 1, 2, …, n, Х = (xij) – матрица наблюдений (исходных данных). В факторном анализе предполагается, что xj является линейной комбинацией m линейно независимых факторов, так называемых «общих факторов» f1, f2, …, fm, плюс «специфический» для данного признака фактор ei, некоррелированный ни с общими факторами, ни с другими специфическими факторами,

(1)

(1)

Будем считать xi центрированными, а факторы – ортогональными:

M(xi) = 0; M(fj) = 0;

M(ei) = 0; σ2(fj) = 1;

σ2(ei) = vi; cov(fi, fj) = 0.

Общие факторы fj являются «причиной» корреляций между признаками xi. Эти факторы представляют собой непосредственно не измеряемые, скрытые (латентные) переменные, в той или иной мере связанные с исходными наблюдаемыми переменными. Ковариационная матрица ∑ исходных признаков xi, в соответствии с моделью факторного анализа (1), может быть представлена в виде

(2)

(2)

где L = (lij) – матрица нагрузок на общие факторы, i = 1, 2, …, p, j = 1, 2, …, m; V – диагональная матрица дисперсий специфических факторов ei. Диагональные элементы матрицы  представляют собой дисперсии признаков, объясняемые m общими факторами. Эти элементы называются общностями, а сама матрица ∑+ – редуцированной корреляционной матрицей.

представляют собой дисперсии признаков, объясняемые m общими факторами. Эти элементы называются общностями, а сама матрица ∑+ – редуцированной корреляционной матрицей.

Выбор метода оценки матрицы нагрузок на общие факторы

Оценки матрицы нагрузок L обычно получают одним из двух способов: методом главных осей или методом максимального правдоподобия [1, 2, 4]. В методе главных осей в качестве оценок матрицы нагрузок выбирают первые m собственных векторов редуцированной корреляционной матрицы ∑+, соответствующие наибольшим собственным значениям матрицы ∑+. В методе максимального правдоподобия оценка матрицы нагрузок получается путём максимизации функции правдоподобия, считая, что вектор наблюдаемых признаков  имеет многомерное нормальное распределение. Хотя оба метода направлены на максимальное приближение внедиагональных элементов корреляционной матрицы, тем не менее методы дают несколько различные результаты. При этом, как показали результаты численного моделирования, метод максимального правдоподобия приближает корреляционную матрицу немного лучше метода главных осей, даже если вектор наблюдаемых переменных

имеет многомерное нормальное распределение. Хотя оба метода направлены на максимальное приближение внедиагональных элементов корреляционной матрицы, тем не менее методы дают несколько различные результаты. При этом, как показали результаты численного моделирования, метод максимального правдоподобия приближает корреляционную матрицу немного лучше метода главных осей, даже если вектор наблюдаемых переменных  не имеет многомерное нормальное распределение. При этом метод максимального правдоподобия имеет под собой строгое математическое обоснование и оценки максимального правдоподобия обладают рядом хороших свойств, как-то: состоятельность, асимптотическая эффективность и асимптотическая несмещённость. Поэтому выбор метода максимального правдоподобия является предпочтительным. Однако метод максимального правдоподобия для оценки матрицы нагрузок не может применяться в некоторых ситуациях, например когда дисперсии специфических факторов равны нулю. В этой ситуации нами предлагается добавить в процесс оценивания преобразование исходных данных, с тем чтобы к преобразованным данным можно было применить метод максимального правдоподобия. Рассмотрим подробнее метод решения задач факторного анализа в этих ситуациях.

не имеет многомерное нормальное распределение. При этом метод максимального правдоподобия имеет под собой строгое математическое обоснование и оценки максимального правдоподобия обладают рядом хороших свойств, как-то: состоятельность, асимптотическая эффективность и асимптотическая несмещённость. Поэтому выбор метода максимального правдоподобия является предпочтительным. Однако метод максимального правдоподобия для оценки матрицы нагрузок не может применяться в некоторых ситуациях, например когда дисперсии специфических факторов равны нулю. В этой ситуации нами предлагается добавить в процесс оценивания преобразование исходных данных, с тем чтобы к преобразованным данным можно было применить метод максимального правдоподобия. Рассмотрим подробнее метод решения задач факторного анализа в этих ситуациях.

При практическом использовании факторного анализа часто возникают следующие ситуации:

1) некоторые специфические факторы отсутствуют в факторной модели;

2) выборочная ковариационная матрица исходных переменных не является положительно определенной.

Пусть  – выборка из р-мерной нормальной совокупности N (0, ∑).

– выборка из р-мерной нормальной совокупности N (0, ∑).

Допустим, что вектор  генеральной совокупности удовлетворяет модели факторного анализа (1)

генеральной совокупности удовлетворяет модели факторного анализа (1)

(3)

(3)

где  – вектор наблюдаемых переменных,

– вектор наблюдаемых переменных,

– векторы общих и специфических факторов соответственно, не наблюдаемые непосредственно; L = (ljk) – матрица нагрузок

– векторы общих и специфических факторов соответственно, не наблюдаемые непосредственно; L = (ljk) – матрица нагрузок  на общие факторы.

на общие факторы.

В модели (3) предполагается, что (m + p)-мерный вектор факторов  имеет нулевое математическое ожидание и ковариационная матрица

имеет нулевое математическое ожидание и ковариационная матрица  имеет вид

имеет вид

где  – единичная матрица;

– единичная матрица;  – диагональная матрица.

– диагональная матрица.

Из модели (3) вытекает, что ковариационная матрица вектора  равна

равна

(4)

(4)

В приложениях факторного анализа возникают следующие задачи [1]:

1. Получение оценок матриц L и V.

2. Оценка числа общих факторов m.

3. Решение первых двух задач в условиях сильной коррелированности переменных, когда некоторые из них являются линейными комбинациями остальных.

Обозначим через S выборочную ковариационную матрицу вектора  .

.

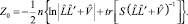

Допустим, что ковариационная матрица ∑ не вырождена. Тогда матрица S имеет распределение Уишарта, и оценка максимального правдоподобия матриц L и V получается из условия максимизации функции Z0 [4, 5]:

(5)

(5)

В литературе описаны два основных подхода к решению задачи максимизации функции Z0 [2, 3, 4]. В обоих известных методах, основанных на них, предполагается, что все оценки дисперсий специфических факторов  отличны от нуля. Однако в практических исследованиях встречаются такие матрицы S, для которых некоторые оценки

отличны от нуля. Однако в практических исследованиях встречаются такие матрицы S, для которых некоторые оценки  близки к нулю. Это может явиться следствием одной из следующих причин:

близки к нулю. Это может явиться следствием одной из следующих причин:

a) в модели (3) некоторые дисперсии специфических факторов vj равны нулю, т.е. размерность вектора факторов  меньше m + р. В данной ситуации при любом объеме выборки некоторые оценки

меньше m + р. В данной ситуации при любом объеме выборки некоторые оценки  могут быть близки к нулю;

могут быть близки к нулю;

б) в модели (3) некоторые vj близки к нулю; в этом случае, если объем выборки был бы достаточно велик, все оценки дисперсий  были бы больше нуля.

были бы больше нуля.

В практических расчетах матрица S иногда не является положительно определенной. Это может быть вызвано тем, что

а) в модели факторного анализа (3) больше, чем m, специфических факторов имеют нулевую дисперсию ( имеет вырожденное распределение);

имеет вырожденное распределение);

б) определитель |∑| близок к нулю, и вследствие недостаточно большого объема выборки или ошибок округления матрица S может оказаться не положительно определённой.

Если S не является положительно определенной, то плотность распределения Уишарта равна нулю и мы не можем воспользоваться для оценки матриц нагрузок L и V функцией максимального правдоподобия [4].

Поскольку проверка гипотез о числе общих факторов производится после того, как определены оценки  и

и  [4], то в рассматриваемых ситуациях мы не сможем проверить эти гипотезы. Если максимум функции правдоподобия (5) ищется методом Лоули [4], то число общих факторов m и начальные приближения оценок

[4], то в рассматриваемых ситуациях мы не сможем проверить эти гипотезы. Если максимум функции правдоподобия (5) ищется методом Лоули [4], то число общих факторов m и начальные приближения оценок  и

и  часто находят центроидным методом. Следует отметить, что в рассматриваемых ситуациях мы не сможем оценить число общих факторов также и в центроидном методе.

часто находят центроидным методом. Следует отметить, что в рассматриваемых ситуациях мы не сможем оценить число общих факторов также и в центроидном методе.

Итак, в ряде случаев нельзя использовать разработанный аппарат оценок максимального правдоподобия матриц  и

и  и, соответственно, проверить гипотезы о числе общих факторов.

и, соответственно, проверить гипотезы о числе общих факторов.

Для решения этих задач можно предложить искусственно увеличивать дисперсии специфических факторов.

Получение оценок матриц L и V

Пусть  – случайная величина с диагональной ковариационной матрицей, не зависящая от

– случайная величина с диагональной ковариационной матрицей, не зависящая от  . Обозначим через

. Обозначим через  выборочную ковариационную матрицу случайного вектора

выборочную ковариационную матрицу случайного вектора  и через

и через  – матрицу выборочных коэффициентов ковариации векторов

– матрицу выборочных коэффициентов ковариации векторов  и

и  ,

,

где  ,

,  – векторы значений

– векторы значений  и

и  в i-м наблюдении, n + 1 – объем выборки.

в i-м наблюдении, n + 1 – объем выборки.

Для того, чтобы дисперсии всех специфических факторов сделать отличными от нуля, прибавим к обеим частям модели (2) вектор  . Тогда модель (2) примет вид

. Тогда модель (2) примет вид

(6)

(6)

где

Матрицы нагрузок на общие факторы L в моделях (3) и (6) совпадают.

Вектор  имеет многомерное нормальное распределение N(0, Σ0), где Σ0 = Σ + Δ.

имеет многомерное нормальное распределение N(0, Σ0), где Σ0 = Σ + Δ.

Выберем диагональную матрицу Δ таким образом, чтобы S0 – выборочная ковариационная матрица вектора  стала положительно определенной и оценки дисперсий всех специфических факторов модели (6) стали отличными от нуля.

стала положительно определенной и оценки дисперсий всех специфических факторов модели (6) стали отличными от нуля.

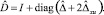

Выборочная ковариационная матрица S0 вектора  будет иметь распределение Уишарта w(Σ0, n). Так как S0 положительно определена, плотность распределения Уишарта в точке S0 отлична от нуля [4]. Следовательно, для оценки матриц L и V0 модели (6) применим метод максимального правдоподобия. Функцию максимального правдоподобия получим, заменив в (5)

будет иметь распределение Уишарта w(Σ0, n). Так как S0 положительно определена, плотность распределения Уишарта в точке S0 отлична от нуля [4]. Следовательно, для оценки матриц L и V0 модели (6) применим метод максимального правдоподобия. Функцию максимального правдоподобия получим, заменив в (5)  на

на  , S на S0 и

, S на S0 и  на

на  . В силу выбора Δ оценки дисперсий специфических факторов положительны. Поэтому для максимизации функции правдоподобия можно воспользоваться любым из двух описанных в литературе подходов. При этом мы получим состоятельные, асимптотически несмещенные и эффективные оценки матриц L и V0. Оценка матрицы нагрузок V на специфические факторы в модели (3) определяется из соотношения

. В силу выбора Δ оценки дисперсий специфических факторов положительны. Поэтому для максимизации функции правдоподобия можно воспользоваться любым из двух описанных в литературе подходов. При этом мы получим состоятельные, асимптотически несмещенные и эффективные оценки матриц L и V0. Оценка матрицы нагрузок V на специфические факторы в модели (3) определяется из соотношения

.

.

В практических задачах часто приходится рассматривать в качестве исходной выборочную корреляционную, а не ковариационную матрицу переменных. В этом случае полученную оценку матрицы нагрузок на общие факторы вектора  необходимо преобразовать, чтобы получить оценку матрицы нагрузок на вектор

необходимо преобразовать, чтобы получить оценку матрицы нагрузок на вектор  .

.

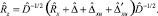

Пусть  – оценка матрицы нагрузок на общие факторы нормированного вектора

– оценка матрицы нагрузок на общие факторы нормированного вектора  ,

,  и

и  – оценки корреляционных матриц нормированных векторов

– оценки корреляционных матриц нормированных векторов  и

и  соответственно.

соответственно.

Очевидно,

(7)

(7)

где

Из (7) получаем

Считая  не зависящей от выборки, легко показать, что

не зависящей от выборки, легко показать, что

где  – оценка матрицы L модели (6).

– оценка матрицы L модели (6).

Оценка  вычисляется по формуле

вычисляется по формуле

Оценка числа общих факторов

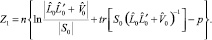

Для проверки гипотез о числе общих факторов используется статистика [4]

Так как матрицы S0 и  не вырождены, то можно теперь для модели (6) проверить гипотезы о числе общих факторов.

не вырождены, то можно теперь для модели (6) проверить гипотезы о числе общих факторов.

Числа общих факторов в моделях (6) и (3) равны между собой.

Очевидно, при фиксированной матрице Δ, Pm → 1 по вероятности при n → ∞, где Рm – вероятность принять гипотезу H0 о числе общих факторов в модели (6), равном m.

Рассмотрим зависимость статистики Z1 от выбора матрицы Δ при фиксированном объеме выборки.

Выборочная ковариационная матрица вектора  равна

равна

(8)

(8)

Оценка максимального правдоподобия матрицы V0 связана с S0 и  соотношением [4]

соотношением [4]

(9)

(9)

Учитывая (8) и (9), нетрудно получить, что при  .

.

(10)

(10)

(11)

(11)

по вероятности.

При Δjj → ∞ оценки  по вероятности, откуда, с учетом соотношений (10) и (11), получаем, что статистика Z1 при

по вероятности, откуда, с учетом соотношений (10) и (11), получаем, что статистика Z1 при  стремится к нулю по вероятности. Следовательно, в этом случае P0 → 1 по вероятности, где P0 – вероятность принять гипотезу H0 о том, что число общих факторов равно нулю.

стремится к нулю по вероятности. Следовательно, в этом случае P0 → 1 по вероятности, где P0 – вероятность принять гипотезу H0 о том, что число общих факторов равно нулю.

Поскольку статистика Z1 с ростом дисперсии «шума» убывает, при решении практических задач оценка числа общих факторов вследствие недостаточного объема выборки может оказаться заниженной. Поэтому численные значения Δjj следует выбирать не слишком большими, лишь бы только новые оценки дисперсий специфических факторов в модели (6) не получились равными нулю. Поскольку дисперсии оценок зависят от объема выборки, то и выбор численных значений Δjj будет зависеть в этом случае от объема выборки.

Факторный анализ направлен на анализ структуры внедиагональных элементов ковариационных матриц. Чем меньшие значения Δjj будут выбраны, тем меньше будут отличаться внедиагональные элементы выборочных ковариационных матриц S и S0 и, следовательно, тем меньшее влияние на оценку матрицы нагрузок L окажет наложенный на статистические данные «шум» (при фиксированном объеме выборки). Это также является аргументом в пользу выбора небольших значений Δjj.

Случай вырожденного распределения

В практических исследованиях может встретиться ситуация, когда какая-то компонента вектора  , например х1, является линейной комбинацией остальных. Рассмотрим, как и выше, вектор

, например х1, является линейной комбинацией остальных. Рассмотрим, как и выше, вектор  и допустим, что Δ11 > 0 (Δ11 – дисперсия u1). Тогда, если независимые переменные х2, х3,…, хp имеют невырожденное многомерное нормальное распределение, то и вектор

и допустим, что Δ11 > 0 (Δ11 – дисперсия u1). Тогда, если независимые переменные х2, х3,…, хp имеют невырожденное многомерное нормальное распределение, то и вектор  будет иметь невырожденное нормальное распределение и можно, таким образом, включить х1 в факторную модель (6). Это дает большую свободу в отборе переменных для факторного анализа, а также может быть использовано при построении уравнения регрессии с помощью факторного анализа.

будет иметь невырожденное нормальное распределение и можно, таким образом, включить х1 в факторную модель (6). Это дает большую свободу в отборе переменных для факторного анализа, а также может быть использовано при построении уравнения регрессии с помощью факторного анализа.

Рецензенты:

Кобелев Н.Б., д.э.н., профессор кафедры «Системный анализ и моделирование экономических процессов», Финансовый университет при Правительстве РФ, Президент НП «Ремесленная палата России», г. Москва;

Киселёва И.А., д.э.н., профессор кафедры «Прикладная математика», МЭСИ, г. Москва.

Библиографическая ссылка

Орлова И.В., Турундаевский В.Б. ВЫБОР МЕТОДА ОЦЕНКИ МАТРИЦЫ НАГРУЗОК В ФАКТОРНОМ АНАЛИЗЕ И АЛГОРИТМ ОЦЕНКИ ПРИ НУЛЕВЫХ НАГРУЗКАХ НА ЧАСТЬ СПЕЦИФИЧЕСКИХ ФАКТОРОВ // Фундаментальные исследования. 2015. № 6-1. С. 161-165;URL: https://fundamental-research.ru/ru/article/view?id=38413 (дата обращения: 02.01.2026).